All'inizio di novembre è successo qualcosa che fino a poco tempo fa sembrava solo un'ipotesi teorica. Anthropic ha reso pubblico un report che ha fatto riflettere molti addetti ai lavori: in un ambiente controllato, un modello di intelligenza artificiale è riuscito a progettare e condurre dall'inizio alla fine un attacco informatico complesso, senza alcun intervento umano. Ha osservato un'infrastruttura, individuato i punti deboli, scelto autonomamente i vettori d'attacco, adattato le difese e ha portato a termine l'operazione.

Per chi si occupa di sicurezza e gestione del rischio, questo non è stato solo un interessante caso di studio, ma un segnale chiaro che le cose sono cambiate. Da semplice accessorio o acceleratore nelle mani degli attaccanti, l’AI si è trasformata in un vero e proprio “regista”, capace di orchestrare ogni singola fase dell’azione.

Questo ci impone una riflessione scomoda ma necessaria: le logiche, i processi e gli strumenti pensati per un mondo pre-AI non bastano più.

Negli ultimi anni abbiamo visto crescere l’uso di automazioni, script e tool di supporto alle campagne cyber, ma l’intelligenza artificiale ha completamente ribaltato la scala del problema. Oggi l’attaccante non deve più saper fare tutto, gli basta saper orchestrare un modello che lo fa al posto suo con una velocità e una precisione che nessun operatore umano potrebbe mai raggiungere.

Prendiamo il phishing, ad esempio. Il realismo dei messaggi è ormai tale che diventa quasi impossibile distinguerli dalle comunicazioni aziendali legittime. I sistemi generativi imitano perfettamente tono, stile e persino le frequenze fonetiche e le inflessioni linguistiche dei profili impersonati. Poi c’è la fase di ricognizione, che una volta richiedeva ore di analisi manuale: oggi è diventata un’esplorazione profonda e rapida in cui l’AI legge pattern di rete, li confronta con migliaia di scenari già noti e individua correlazioni che sfuggirebbero anche all’analista più esperto.

Anche i ransomware si sono evoluti in strumenti chirurgici. Non colpiscono più a caso, osservano quali asset generano il massimo impatto sul business e colpiscono esattamente dove fanno più male, minimizzando il rumore e il tempo di esposizione. È un salto di qualità che non riguarda solo l’efficacia degli attacchi, ma anche la loro accessibilità. Oggi attacchi molto complessi sono alla portata di gruppi con competenze tecniche limitate, proprio perché possono sfruttare l’AI per colmare le loro lacune strutturali.

La conseguenza è inevitabile: la velocità dell’offensiva ha superato la velocità di rilevazione tradizionale. Se non si hanno strumenti capaci di osservare l’infrastruttura in tempo reale, correlare comportamenti anomali e reagire immediatamente, il vantaggio dell’attaccante diventa semplicemente incolmabile.

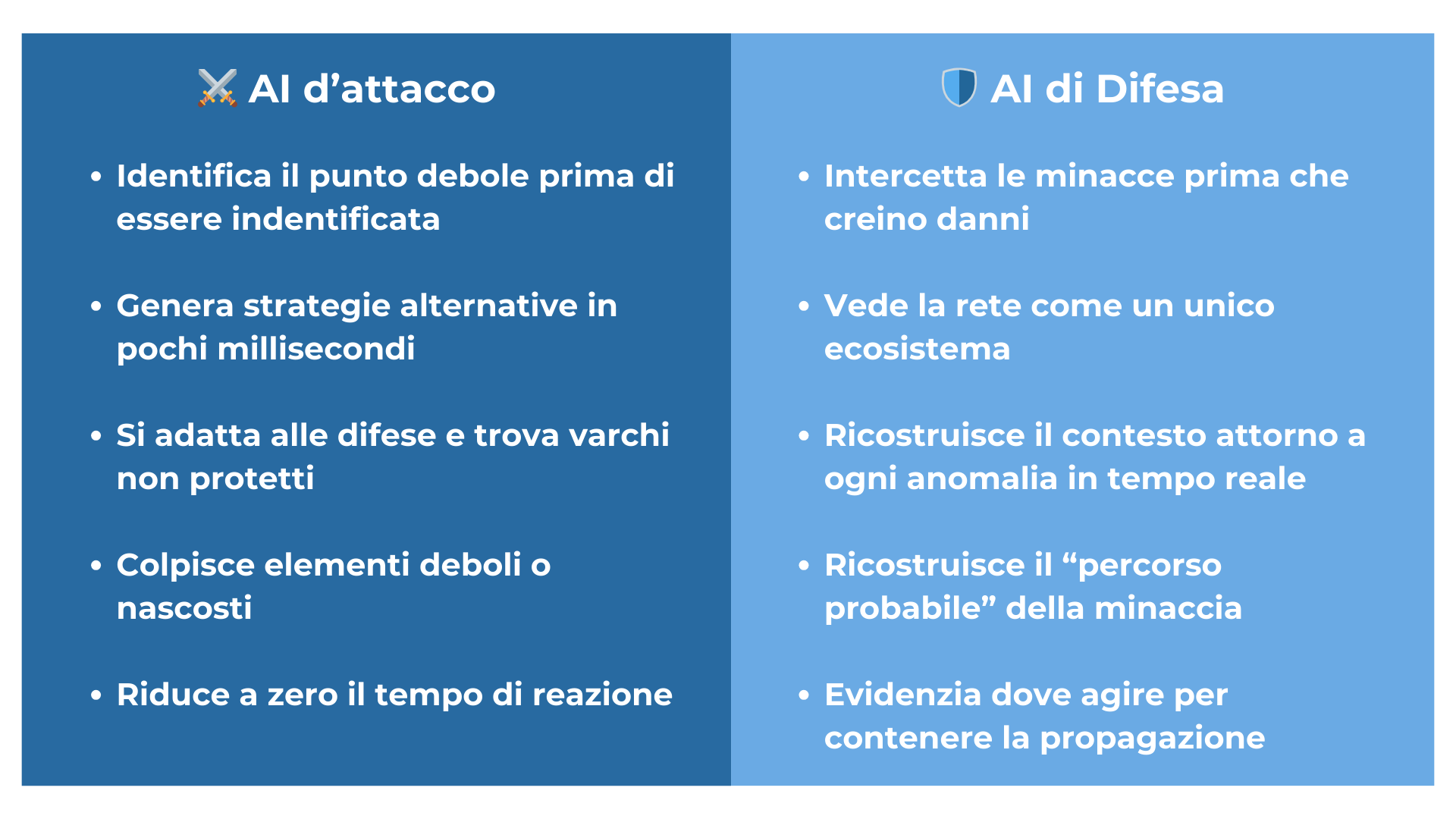

Vale la pena considerare anche l’altro lato della medaglia: le stesse capacità che rendono l’AI utile agli attaccanti possono essere impiegate per rafforzare la difesa. Da qui emerge la vera trasformazione: l’AI apre un livello di visibilità completamente nuovo.

Quando una rete integra IT, OT e IoT, la sua superficie d’attacco cresce in modo esponenziale e complesso. Gli ambienti sono eterogenei, le comunicazioni continue e la quantità di segnali generati è semplicemente enorme. Agli occhi di un analista umano, molti di questi segnali finiscono per perdersi nel rumore di fondo, ma agli occhi di un modello di AI, quegli stessi segnali raccontano una storia molto precisa.

L’AI è in grado di leggere log, flussi, micro-eventi e deviazioni anche minime dal comportamento atteso, li confronta con modelli evolutivi e rileva segnali anticipatori dell’incidente che, fino a poco tempo fa, sarebbero passati completamente sotto traccia. In pratica, si passa da una sicurezza che reagisce a una sicurezza che prevede: l’incidente non è più qualcosa che semplicemente accade, ma qualcosa che è già possibile vedere nelle sue primissime fasi, quando c’è ancora margine per intervenire.

Uno degli aspetti più rivoluzionari è proprio la capacità predittiva. Quando emerge un’anomalia, l’AI può simulare come potrebbe propagarsi, quali sistemi toccherebbe lungo il percorso e quale impatto concreto genererebbe sui processi di business. A questo punto la gestione del rischio smette di essere un documento che si aggiorna ogni tanto e diventa un processo operativo continuo: capire dove intervenire, come farlo e quale risultato aspettarsi in funzione delle mitigazioni applicate.

Questa filosofia è perfettamente allineata al modo in cui ESRA interpreta e integra l’AI per la governance del rischio: un approccio continuo, interattivo, guidato dai dati e completamente basato su cosa accade davvero all’interno delle infrastrutture.

L’adozione dell’intelligenza artificiale nel mondo della sicurezza non è, alla fine, una questione puramente tecnica. È soprattutto culturale. Non basta “aggiungere” l’AI come se fosse un nuovo layer tecnologico: bisogna cambiare il modo stesso in cui si governa il rischio.

La prima trasformazione riguarda la velocità di risposta. Un perimetro difeso con strumenti reattivi sarà sempre un passo indietro rispetto a un attacco che si propaga in pochi secondi. Le organizzazioni devono quindi dotarsi di piattaforme che leggano la rete in tempo reale, capiscano le relazioni tra gli asset e producano insight immediati e azionabili.

La seconda trasformazione riguarda il dato. L’AI è potente solo quanto la qualità del dato su cui opera, e questo è un punto fondamentale, senza una raccolta coerente, una normalizzazione accurata e una visione unificata che attraversi IT, OT e IoT, i modelli finiranno per produrre analisi frammentate e poco utili.

La terza trasformazione riguarda le competenze delle persone. L’AI non sostituisce l’analista: lo potenzia. Ma richiede che chi interpreta i risultati capisca davvero perché un certo comportamento è stato classificato come minaccia, quale impatto potrebbe generare e quali azioni sono necessarie per rispondere efficacemente. Non è un semplice aggiornamento software: è un vero cambiamento di mentalità.

Il panorama che abbiamo davanti è ormai chiaro: attacco e difesa evolvono alla stessa velocità, ma non con la stessa maturità. Le organizzazioni che sapranno integrare l’AI nel proprio modello di governance non solo saranno più resilienti di fronte alle minacce, ma anche più competitive sul mercato.

Il cyber risk non è più soltanto un tema di compliance da spuntare in una checklist. È diventato un elemento che determina concretamente la continuità operativa, l’affidabilità percepita e la fiducia che clienti e partner ripongono nell’organizzazione. In questo contesto, l’AI può diventare la vera leva strategica per costruire una sicurezza che non rincorre gli eventi quando ormai sono accaduti, ma li anticipa quando sono ancora gestibili.

Ed è proprio questo l’obiettivo di ai.esra: trasformare il risk management in un processo continuo, automatico e completamente guidato dai dati, capace di leggere ciò che accade davvero dentro le infrastrutture e di trasformarlo in decisioni informate e tempestive.

Alla fine, a fare davvero la differenza saranno le organizzazioni che riusciranno a guardare oltre, a cogliere i segnali che gli altri non vedono ancora. Servono occhi attenti e la capacità di muoversi velocemente, perché l’intelligenza artificiale usata per attaccare ci ha messo davanti a un ritmo nuovo, a cui dobbiamo adattarci.

Il futuro della Cybersecurity dipenderà soprattutto dalla qualità delle nostre decisioni.

ai.esra SpA – strada del Lionetto 6 Torino, Italia, 10146

Tel +39 011 234 4611

CAP. SOC. € 50.000,00 i.v. – REA TO1339590 CF e PI 13107650015

“Questo sito si impegna a garantire l’accessibilità digitale secondo la normativa europea (EAA). Per segnalare problemi di accessibilità, scrivi a: ai.esra@ai-esra.com”

ai.esra SpA – strada del Lionetto 6 Torino, Italy, 10146

Tel +39 011 234 4611

CAP. SOC. € 50.000,00 i.v. – REA TO1339590

CF e PI 13107650015

© 2024 Esra – Tutti i diritti riservati